最近不少云厂商都推出了云主机包年优惠活动,虽然配置不高但好在有公网 IP,恰好家里有一台 Mac mini 在吃灰,花了三杯咖啡钱买了一年某云的云主机打算将其和家里的 Mac mini 组成 k8s 集群,方便平时学习和测试同时也能通过云主机的公网 IP 访问到 Mac mini 上运行的服务。为了方便讲解下面以 ecs 和 macmini 表示两台主机,先来看看两台主机的网络信息:

ecs

- eth0

172.19.174.87 - internet

47.102.84.170

- eth0

macmini

- eth0

172.16.14.253

- eth0

两台主机处于不同的网络中,其中 ecs 主机具有公网 IP,很显然这两台主机并不满足 k8s 的网络要求,因此需要先使用 ZeroTier 组建一个虚拟局域网将两台主机连接起来。ZeroTier 是一个基于 P2P 的虚拟局域网软件,理论上只要主机连接了互联网就能与其它主机组成虚拟局域网,并且组网的主机不需要有公网 IP。使用 ZeroTier 组网非常简单,再加上网上已经有非常多关于 ZeroTier 的相关教程所以组网流程简单带过。

组建虚拟局域网

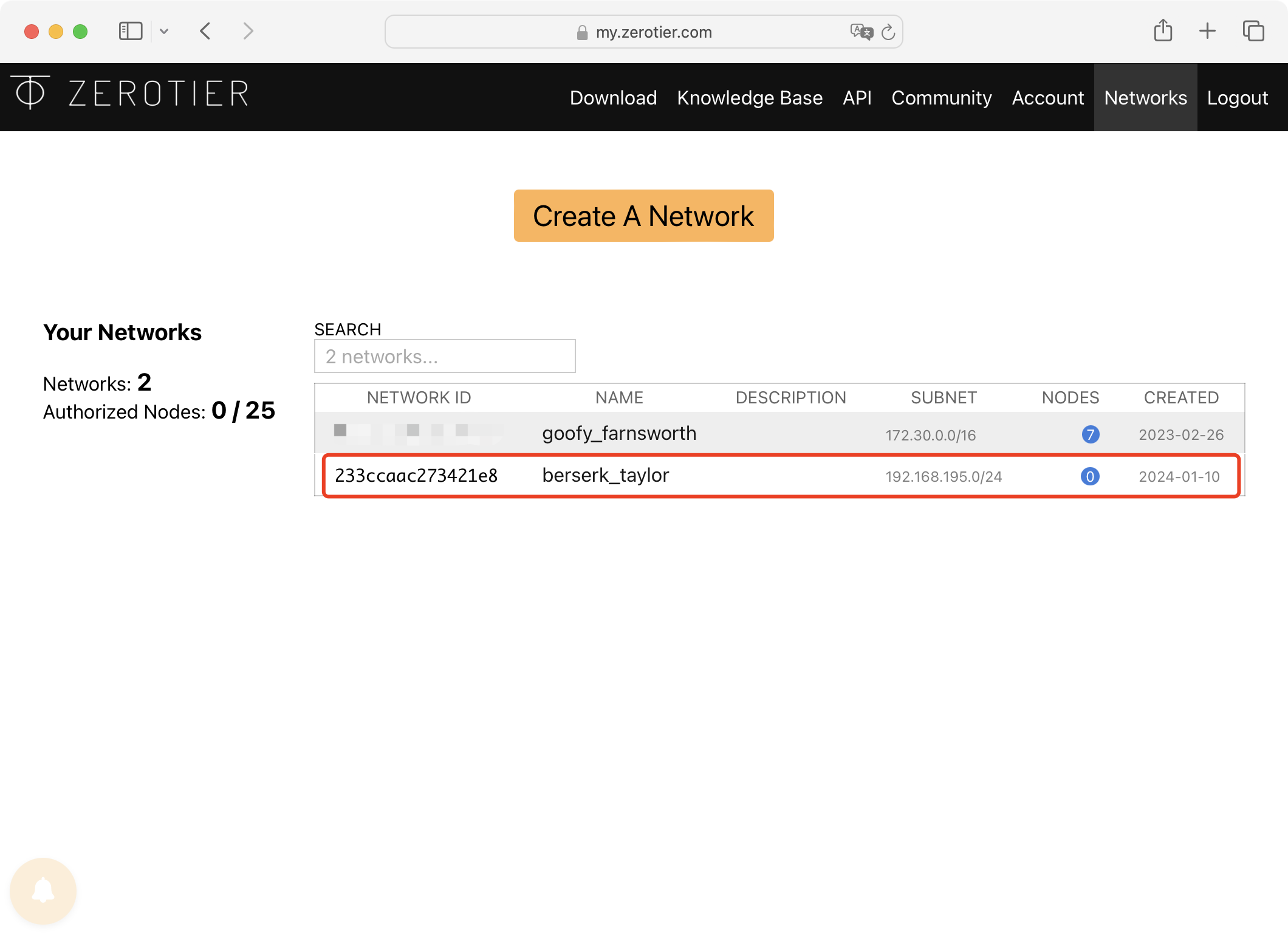

打开 ZeroTier 官网 注册一个账户,可以用 Github 或者 Google 账户注册,注册完毕后进入到个人页面,点击 Create A Network 按钮创建一个网络,创建成功后下方会出现网络的信息:

Network ID 是网络的唯一标识,主机可以通过这个标识加入网络。主机加入网络后 ZeroTier 会在 Subnet 指定的网段内给主机分配 IP 地址,如果网段与主机网络的网段有冲突则需要点击网络进入网络管理页面,在 IPv4 Auto-Assign 栏中修改网段。

网络创建好之后就可以将主机加入到网络中,加入网络流程也非常简单,在 下载页面 下载对应操作系统的客户端安装即可,Linux 系统可以使用以下命令一键安装:

1 | curl -s https://install.zerotier.com | sudo bash |

ZeroTier 客户端包含核心程序 zerotier-one 以及命令行管理工具 zerotier-cli,安装完毕后就可以使用管理工具将主机加入到创建好的虚拟网络中:

1 | $ zerotier-cli join <network-id> |

将 <network-id> 替换为刚创建的网络 Network ID,返回 200 join OK 表示正常,接下来在需要组网的主机上重复以上步骤即可。

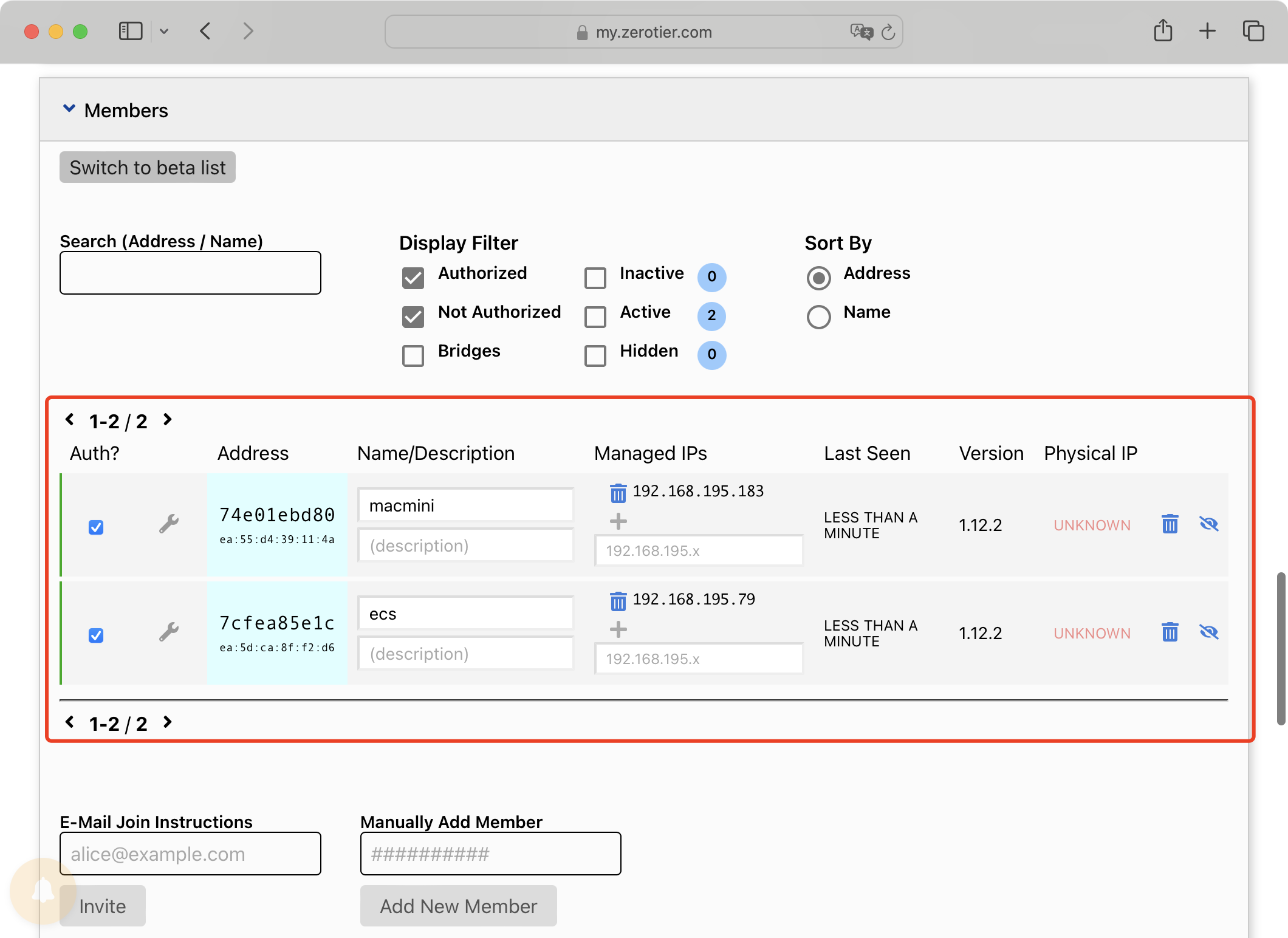

所有主机都操作完后回到 ZeroTier 控制台,点击刚创建的网络进入网络管理页面,下拉找到 Members 栏就会看到刚加入的主机,选中主机前面的 Auth? 复选框授主机加入网络,稍等片刻后刷新页面,在 Managed IPs 列可以看到 ZeroTier 为主机分配的 IP 地址,网络中的主机可以通过这个 IP 地址与其它主机进行通信。

在主机上执行 zerotier-cli listnetworks 命令可以查看主机所加入的网络信息:

1 | zerotier-cli listnetworks |

为了更好的区分主机可以给主机设置 short-name,这个名字并不只是起到装饰作用,配合 ZeroTier 提供的 ZeroNSD 可以通过这个名字访问指定的主机,如同 k8s 集群中使用 .cluster.local 域名访问 Service,具体操作流程这里就不展开了感兴趣的同学可以看官方文档。

从图中可以看到 ecs 主机分配的 IP 地址为 192.168.195.79,macmini 主机分配的 IP 地址为 192.168.195.183,下面在 ecs 使用虚拟局域网 IP 来 ping 一下 macmini 测试网络连通性:

1 | ping 192.168.195.79 -c 3 |

到这里两台处于不同网络的主机已经可以通过 ZeroTier 网络相互通信了,需要注意的是网络连接质量与主机所处的网络有关。理想情况下主机之间是通过 P2P 直接通信的,但在建立通信前仍需向 ZeroTier 服务器请求对方主机的信息所以第一个 PING 的延迟会比较高。即使两台主机可以直接通信,所处的网络有防火墙或者 NAT 网络也会导致网络连接质量下降。云主机机房是在我所在的城市所以与家里的 Mac mini 连接质量还不错,但在离家不到五公里的公司访问虚拟局域网内的主机会严重丢包甚至无法连接,所以连接质量还是与主机所在的网络有关。

最坏的情况下主机之间无法直接通信,此时 ZeroTier 会通过中继服务器转发数据包,这种情况下网络连接质量会非常差,但可以通过搭建 moon 节点来优化,具体流程可以参考 ZeroTier 官方文档 这里就不展开讨论。

主机加入网络后 ZeroTier 会在主机上新增一个以 zt 开头的虚拟网卡,也就是 zerotier-cli listnetworks 命令 <dev> 列的值,在我的主机上名字是 ztr4n75dop,这块网卡的名字非常重要,后面我们会用到它。

到这里组网就完成了,最后来汇总一下主机的网络信息:

ecs

- eth0

172.19.174.87 - internet

47.102.84.170 - ztr4n75dop

192.168.195.79

- eth0

macmini

- eth0

172.16.14.253 - ztr4n75dop

192.168.195.183

- eth0

搭建 k8s 集群

解决了节点间的连通问题后就可以按照正常流程部署 k8s 集群了,唯一需要注意的是 cni 插件要使用 ZeroTier 创建的虚拟网卡来完成节点间的通信。下面使用轻量化 k8s 发行版 k3s 来搭建集群,由于云主机的配置比较低所以我 macmini 主机作为 master 节点。

k3s 为我们提供了几种配置集群的方法,这里使用 命令行参数 方式配置 master 节点:

以下命令用到的 IP 地址请按照实际情况替换

1 | curl -sfL https://rancher-mirror.rancher.cn/k3s/k3s-install.sh | INSTALL_K3S_MIRROR=cn INSTALL_K3S_EXEC=server sh -s - \ |

解释一下关键参数:

--flannel-iface=ztr4n75dop指定 flannel 使用 ZeroTier 虚拟网卡--flannel-backend=host-gw使用 flannel 使用性能更好的 host-gw 模式--tls-san=192.168.195.183将 master 节点的 ZeroTier IP 添加到 TLS SAN 中,以便后续通过这个 IP 访问 k8s 集群--tls-san=47.102.84.170将云主机公网 IP 添加到 TLS SAN 中,以便后续通过公网 IP 访问 k8s 集群

安装命令执行完毕使用 k3s kubectl get no 命令查看 master 节点状态:

1 | k3s kubectl get no |

master 节点 Ready 后就可以配置 worker 节点了,在此之前需要在 master 节点上执行 k3s token create 命令生成一个 bootstrap token。接着在 worker 节点上执行以下命令:

1 | curl -sfL https://rancher-mirror.rancher.cn/k3s/k3s-install.sh | INSTALL_K3S_MIRROR=cn INSTALL_K3S_EXEC=agent sh -s - \ |

worker 节点的安装参数与 master 节点稍微有点区别:

--server=https://192.168.195.183:6443指定 master 节点的地址--node-label=svccontroller.k3s.cattle.io/enablelb=true为 worker 节点添加svccontroller.k3s.cattle.io/enablelb标签,拥有这个标签的节点会被 k3s 用作集群负载均衡的节点,因为 worker 节点有公网 IP 所以需要将这个标签添加到 worker 节点上--node-external-ip=172.19.174.87将 eth0 网卡的 IP 地址设置为节点的 external ip,k3s 会用这个 IP 地址作为 Service 的 LoadBalancer IP

需要注意的是 --node-label=svccontroller.k3s.cattle.io/enablelb=true 与 --node-external-ip=172.19.174.87 这两个参数需要加到拥有公网 IP 的节点上,无论这个节点是 worker 还是 master。

稍等片刻后回到 master 节点上确认一下 worker 节点的状态:

1 | k3s kubectl get no |

到这里集群就搭建完毕了,通过 ZeroTier 虚拟网络两台「相隔千里」的主机成功组成了一个 k8s 集群!

访问集群

为了方便运维可以将 APIServer 通过公网 IP 暴露出来,这样就可以通过公网 IP 访问集群了,在 master 节点创建 /root/apiserver-expose.yaml 文件:

1 | # /root/apiserver-expose.yaml |

执行 k3s kubectl apply -f /root/apiserver-expose.yaml 命令创建 Service,然后将 master 节点上 /etc/rancher/k3s/k3s.yaml 文件复制到本地 /root/.kube/config,将里面 server 字段的 IP 替换为云主机的公网 IP,注意端口要修改为 8443,最后在云主机管理后台放行 8443 端口,然后就可以在本地使用 kubectl 访问集群了。

ingress

k3s 自带 traefik ingress controller,我们可以创建一个 whoami 应用测试一下 ingress 是否正常工作:

1 | # /root/whoami.yaml |

我特意将 Pod 部署在 macmini 节点,以便验证是否可以通过云主机的公网 IP 访问 macmini 上运行的服务。将配置文件提交到 k8s 后就可以进行测试了:

1 | curl http://47.102.84.170/whoami |

可以看到 ingress 正常工作,但是从 whoami 输出的 X-Real-Ip 头可以看出 whoami 并没有获取到正确的客户端 IP,通过 X-Forwarded-For 头可以断定根因是 traefik 没有获取到客户端 IP 地址。有经验的同学立马就知道问题出在哪里:

1 | k3s kubectl get svc/traefik -n kube-system -o=jsonpath='{.spec.externalTrafficPolicy}' |

问题就出在 traefik Service 的 externalTrafficPolicy 字段,关于这个字段的作用以及会如何影响客户端 IP 大家可以查看 k8s 官方文档 这里就不展开讨论了,解决方案是将 externalTrafficPolicy 字段修改为 Local。k3s 使用 Helm Controller 来管理 traefik 所以我们要在 /var/lib/rancher/k3s/server/manifests/traefik.yaml 文件进行修改:

1 | # /var/lib/rancher/k3s/server/manifests/traefik.yaml |

这里对 traefik Chart 的 Values 进行了两处修改:

service.spec将 Service 的externalTrafficPolicy修改为LocalnodeSelector将 traefik 部署在集群负载均衡节点,因为 externalTrafficPolicy 字段设置为 Local 后外部流量进入集群后不会进行转发,云主机是外部流量的入口,如果云主机上没有 traefik Pod 那么就无法处理请求了,而macmini节点没有公网 IP 因此不会有外部流量流入,没有必要部署 traefik。

修改完毕后 Helm Controller 会自动应用更改,稍等片刻后再次访问 whoami 应用:

1 | curl http://47.102.84.170/whoami |

可以看到修改后 traefik 获取到了真实的客户端 IP 地址并传递给了 whoami,至此就可以通过公网 IP 访问集群以及 macmini 上运行的应用了!